1. Asumsi-asumsi ini adalah asumsi semua teknik statistik parametrik. Yang benar adalah, asumsi-asumsi ini adalah asumsi dari teknik statistik tertentu. Jadi ketika kita membahas t-test, maka asumsi-asumsi ini adalah asumsi dari t-test. Kebetulan saja beberapa asumsi sama antara satu teknik dengan teknik yang lain. (Ini juga merupakan pemahaman saya dulu yang ternyata keliru). Atau beberapa asumsi dari teknik yang berbeda itu sama karena didasarkan pada model yang sama (kita akan membahas ini nanti ketika membahas anava, anareg, dan anakova).

2. Pelanggaran terhadap asumsi yang manapun dapat dipecahkan dengan menggunakan statistik non parametrik. Menurut saya penggunaan statistik non parametrik (distribution free statistics) hanya dapat mengatasi pelanggaran asumsi normalitas saja bukan asumsi yang lainnya. Pelanggaran terhadap asumsi lain (seperti homogenitas varians) hanya dapat diatasi dengan pendekatan yang berbeda dari statistik non parametrik.Pendekatan ini akan dibahas jika nanti kita bertemu dengan tema terkait.

3. Asumsi dari suatu test tidak perlu diuji pemenuhannya oleh data kita. Saya sendiri kurang yakin dengan alasan di balik pendapat ini. Tapi dari yang saya ketahui, pelanggaran asumsi dapat berakibat fatal terhadap kesimpulan yang kita ambil. Bahwa tidak semua asumsi dapat diuji pemenuhannya oleh data kita dengan mudah, itu benar. Beberapa asumsi statistik cukup ribet untuk diuji pemenuhannya oleh data yang tersedia. Beberapa asumsi lain dianggap dapat dipenuhi sejauh teori yang mendasarinya diasumsikan memenuhi asumsi statistik tersebut (bribet banget nggak sih?). Selain itu ada beberapa asumsi yang hampir mustahil untuk dipenuhi dalam penelitian yang sebenarnya, sehingga sejauh kondisi penelitian memuaskan maka asumsi ini dianggap dipenuhi.

4. Pengujian asumsi hanya perlu dilakukan sekali untuk semua analisis yang kita lakukan dalam penelitian. Yang benar adalah bahwa pengujian asumsi harus dilakukan untuk setiap analisis yang berbeda yang kita lakukan dalam suatu penelitian. Analisis yang berbeda di sini maksudnya adalah ketika kita menggunakan teknik yang berbeda atau menggunakan teknik yang sama tetapi menganalisis variabel yang berbeda.

5.Jika uji asumsi gagal maka analisis tidak dapat dilakukan lagi. Ini juga pemahaman yang keliru yang sering membuat jantung para mahasiswa berdegup kencang ketika melakukan uji asumsi. Saya masih ingat teman saya memilih tidak melihat hasil uji asumsi yang dilakukannya selama dua hari untuk menenangkan diri dan mengumpulkan keberanian dulu (true story lho), seakan-akan uji asumsi gagal maka tamatlah riwayatnya. Pelanggaran asumsi jelas dapat membuat ketidaktepatan hasil analisis, tapi tidak selalu berarti analisis tidak dapat digunakan sama sekali. Terkadang hasil analisis masih dapat digunakan dengan beberapa warning atau pemberitahuan akan kelemahan dan keterbatasan. Atau analisis masih dapat dilakukan dengan mengubah bentuk data atau menggunakan pendekatan yang berbeda terhadap data. Terkadang pelanggaran asumsi dapat diabaikan jika kita memiliki alasan kuat mengenai pengabaian yang kita lakukan, atau test yang kita lakukan itu cukup tangguh (robust) mengatasi pelanggaran asumsi.

6. Teknik statistik yang robust berarti dapat mengatasi semua pelanggaran asumsi. Ini sebenarnya masih terkait dengan no 5. Kalo no 5 itu pandangan pesimis, yang ini terlalu optimis. Teknik statistik seperti t dan F memang dapat dibilang robust ketika harus berhadapan dengan beberapa pelanggaran asumsi. Beberapa di sini yang saya tahu hanya asumsi normalitas. Statistik t dan F akan memberikan hasil yang benar-benar keliru (dalam arti tidak dapat ditolerir) jika asumsi homogenitas varian dilanggar. Jadi ke-robust-an t dan F hanya terkait dengan normalitas sebaran data.

Argumentasi saya akan diberikan dalam penjelasan mengenai asumsi t-test ini, beberapa saya tuliskan dalam posting yang berbeda ketika membahas teknik statistik terkait.

Baiklah, jadi apa saja asumsi dari t-test? Beberapa asumsi yang disebutkan di sini berlaku umum, dalam arti asumsi tersebut disyaratkan oleh semua t-test. Beberapa bersifat khusus hanya berlaku untuk t-test tertentu saja. Saya akan memberitahu ketika sampai pada penerapan yang sifatnya khusus.

Dalam pembahasan di posting sebelumnya, saya beberapa kali menyebutkan “probabilitas jika diambil secara random”. Nilai p yang kita dapatkan dari uji statistik tertentu adalah probabilitas dari munculnya statistik tersebut dalam distribusinya jika pengambilan sampel dilakukan secara random.

Jadi jika pengambilan sampel dilakukan tidak dengan random maka p yang kita dapatkan tidak berlaku lagi. Kita cenderung untuk mendapatkan p yang lebih kecil dari yang seharusnya atau underestimasi nilai p. Hal ini membuat keterwakilan populasi dalam sampel dipertanyakan. Apakah benar hasil yang kita dapatkan dari analisis dapat digeneralisasi ke seluruh populasi? Misalnya ditemukan bahwa siswa putra lebih tinggi hasil tes matematiknya daripada siswa putri, apakah temuan ini dapat digeneralisasi ke seluruh populasi.Ataukah ini hanya kebetulan yang diakibatkan kesalahan pengambilan sampel yang tidak random?

Asumsi ini tentu saja sulit dipenuhi dengan baik dalam hampir semua penelitian (apalagi dengan keterbatasan dana dan tenaga seperti yang dialami mahasiswa...S1 lagi…). Oleh karena itu ada beberapa hal yang dapat dilakukan terkait dengan asumsi ini:

1. Dalam penelitian eksperimen, ketertarikan kita lebih pada efek dari treatment yang kita berikan bukan mean populasi secara keseluruhan. Oleh karena itu, jika kita melakukan random assignment, analisis dan hasilnya masih dapat diinterpretasi dengan baik. Kita masih dapat mengambil kesimpulan yang tepat mengenai efek dari treatment yang kita berikan. Ini diakibatkan random assignment akan menghilangkan bias dalam memasukkan subjek ke dalam kelompok sehingga perbedaan di antara dua kelompok dapat disimpulkan sebagai akibat dari adanya treatment. Yang perlu ditekankan disini adalah ‘ketertarikan lebih pada efek dari treatment’. Maksud saya, sekalipun kita melakukan random assignment, tapi jika tidak melakukan random sampling, kita tidak dapat melakukan generalisasi efek treatment ini ke populasi. Dibutuhkan replikasi-replikasi penelitian pada populasi yang sama untuk memastikan generalisasi dari efek treatmen ini.

2. Dalam penelitian non-eksperimental, kita mengalami masalah yang lebih besar (sejauh yang saya pelajari, teknik statistik memang selalu bermasalah dengan penelitian non-eksperimental … entah kapan akurnya…). Tujuan kita dalam penelitian ini hampir selalu membandingkan dua sampel yang berasal dari dua populasi, dan kemudian hasil dari perbandingan dua sampel itu akan digeneralisasi ke dua populasi. Misalnya kita ingin membandingkan Indeks Prestasi (IP) dari dua kelompok subjek yang berbeda daerah. Jika perbedaan terjadi di sampel dan teruji secara statistik, kita masih tidak dapat mengatakan bahwa perbedaan ini terkait dengan perbedaan asal daerah.Sangat mungkin, meskipun tanpa sengaja, kita mengambil mahasiswa yang ‘pandai’ untuk sampel yang satu dan mahasiswa ‘biasa saja’ untuk sampel lain. Peneliti perlu melakukan beberapa hal terkait dengan isu ini.

(1). Peneliti perlu mengumpulkan informasi sebanyak mungkin mengenai variabel lain dari subjek yang ikut menyumbang terhadap perbedaan IP seperti Inteligensi, asal sekolah, dll. Jadi selain dikumpulkan data mengenai IP, perlu juga dikumpulkan data mengenai Inteligensi tiap mahasiswa.

(2). Peneliti kemudian harus bisa menunjukkan bahwa kedua kelompok tidak memiliki perbedaan dalam semua variabel yang terkait dengan IP. Namun demikian analisis menguji ‘kesamaan’ (sebagai lawan uji perbedaan) antara dua kelompok untuk tiap variabel ini tetap tidak memberikan hasil yang memuaskan karena dilakukan sebagai usaha ‘menerima’ hipotesis nol (dalam pandangan statistik sangat sulit untuk ‘menerima’ suatu hipotesis sebagai benar karena ini mengasumsikan adanya p=1.0. Yang paling memungkinkan adalah ‘gagal menolak’ atau ‘tidak memiliki bukti kuat untuk menolak’ hipotesis nol).

(3). Peneliti dapat juga memasangkan subjek berdasarkan variabel-variabel tersebut, sehingga analisis dilakukan dengan mengasumsikan kedua sampel saling dependen. Dengan demikian analisis akan beralih dari t-test untuk sampel independen menjadi t-test untuk sampel yang dependen (matched paired, paired sample). Atau membuat variabel lain menjadi kovarian lalu mengganti analisis menjadi anakova. Kedua pemecahan ini tetap tidak memberikan hasil memuaskan mengingat kita tidak memiliki seluruh variabel yang menyumbang terhadap variasi IP. Kalaupun kita dapat mengumpulkan seluruh variabel, dibutuhkan sangat banyak subjek untuk dapat membuat analisis berjalan dengan baik.

(4). Semua usaha di atas perlu dan memang sebaiknya dilakukan untuk ‘memperkecil’ kesalahan pengambilan kesimpulan. Namun demikian, seperti yang telah dipaparkan, semua usaha itu tidak dapat menggantikan pengambilan subjek secara random. Oleh karena itu perlu bagi peneliti untuk mencantumkan pelanggaran asumsi ini dan usaha yang telah dilakukan sebagai kelemahan penelitian dan usaha untuk mengatasi kelemahan. Usaha ini saya pandang perlu untuk memberikan informasi yang tepat pada pembaca, tidak terlalu berlebihan (over pede) dan mengurangi kesimpulan yang salah arah, yang seringkali berdampak besar. (masih ingat penelitian mengenai efek mozart? Penelitian ini gagal direplikasi, digeneralisasi secara ngawur pada subjek yang berbeda, tapi banyak dipercaya oleh para praktisi yang kemudian menganjurkannya, menyebabkan terjualnya jutaan kopi dari program, kaset/CD dan bukunya tentu saja dan berdampak pada meningkatnya penghasilan beberapa orang…well ini sisi baiknya sepertinya).

Independensi observasi.

Maksudnya observasi terhadap subjek satu dengan yang lain harus independen satu dengan yang lain. Atau dengan kata lain, hasil observasi dari satu subjek tidak memberikan prediksi apapun mengenai hasil observasi dari subjek lain.

1.Jika subjek satu dengan yang lain juga saling mempengaruhi hasil observasi. Contoh subjek menyontek atau memberi contekan subjek lain pada saat pengetesan atau ketika sekelompok orang yang cenderung memberikan respon yang sama seperti orang yang terlibat pertemanan kemudian diwawancarai bersamaan. Respon yang diberikan teman akan dapat mempengaruhi respon yang diberikan seseorang.

2.Jika kita menggunakan lebih dari satu observer, maka sangat mungkin hasil observasi satu subjek dependen terhadap hasil observasi subjek yang lain misalnya jika observer secara tidak sadar membandingkan observasi subjek pertama dengan subjek berikutnya.

3. Jika subjek mengetahui perilaku subjek lain dan kemudian menyesuaikan perilakunya (bisa dalam arti menyamakan atau membuat berbeda). Misalnya jika dalam eksperimen, kelompok kontrol merasa ‘dianaktirikan’ karena tahu bahwa mereka tidak diberi perlakuan khusus, maka mereka cenderung untuk berusaha sekuat tenaga untuk membuktikan bahwa mereka bisa.

4. Jika kita melakukan observasi antar waktu, maka akan ada kemungkinan bahwa perilaku seseorang dalam observasi di suatu waktu mempengaruhi hasil observasi orang yang sama di waktu yang berbeda. Contoh paling konkret adalah jika seseorang diminta mengisi skala dua kali pada dua kesempatan yang berbeda. Jika orang ini masih mengingat respon pada kesempatan pertama, ia mungkin akan memberikan respon yang tidak jauh berbeda pada kesempatan kedua.

Jika observasi satu dengan yang lain tidak independen, maka kita sebenarnya kehilangan lebih banyak derajat kebebasan yaitu sebanyak observasi/subjek yang saling mempengaruhi dalam penelitian. Ini membuat estimasi p dalam sampel menjadi terlalu kecil dibandingkan yang sebenarnya atau kita melakukan underestimasi nilai p.

Selain itu, estimasi standard error akan cenderung lebih kecil daripada yang sebenarnya, sehingga kita akan melakukan overestimasi nilai t yang kita dapatkan.Hal ini akan mengakibatkan underestimasi p, sehingga kita akan cenderung untuk melakukan tipe error I yang lebih besar (misalnya p yang kita temukan 0.05 padahal sebenarnya 0.1).

Asumsi ini mungkin asumsi yang paling sering dilakukan oleh peneliti ketika melakukan analisis data statistik menggunakan t-test. Mengapa asumsi ini ada? Mengapa kita perlu memastikan bahwa data kita mengikuti distribusi normal?

Alasan utamanya terletak pada pembuatan tabel t yang dihasilkan dari perhitungan menggunakan populasi yang memiliki distribusi yang normal. Oleh karena itu, jika distribusi populasi penelitian kita tidak normal, bentuk distribusi t yang dihasilkan tidak seperti yang dituliskan dalam tabel pada umumnya. Artinya, jika kita menggunakan tabel pada umumnya untuk mengecek t yang kita dapatkan, kita akan melakukan kesalahan estimasi p. Misalnya seharusnya 0.2, menjadi terlihat seolah 0.05 di tabel.

“Maaf, Pak. Kami pake program komputer untuk analisis statistiknya”. Kalo itu sama saja, karena formula yang digunakan untuk mengestimasi p dalam program analisis statistik juga dihasilkan dari distribusi yang normal. Jadi akan tetap mengalami kesalahan estimasi. Kecuali, jika dengan program komputer kita membuat distribusi t yang baru yang didasarkan pada bentuk distribusi populasi dalam penelitian kita. “

Untungnya…ada kabar baik. Ternyata t-test termasuk test yang robust ketika harus berhadapan dengan ketidaknormalan data khususnya jika ketidaknormalan populasi tidak terlalu parah. Melalui beberapa percobaan dapat diketahui bahwa penyimpangan p yang kita dapatkan dari analisis dari p yang sebenarnya tidak terlalu jauh berbeda.

Selain itu dalam central limit theorem disebutkan juga bahwa bagaimanapun bentuk distribusi data di populasinya, semakin besar sampel semakin normal distribusi mean sampelnya (Keppel & Wickens, 2004; Howell, 1984). Dan distribusi terlihat ‘cukup’ normal ketika sampel berisi sekitar 30 orang. Mungkin ini juga alasan mengapa kita sering mendengar ‘minimal sampel’ sebesar 30 orang. Pembahasan mengenai besar sampel akan dilakukan tersendiri.

Jadi aman-aman saja? Tunggu dulu.

Lalu apa yang dapat kita lakukan jika asumsi ini dilanggar? Non parametrik? Hehe sabar ya. Pelanggaran asumsi ini tidak selalu harus diatasi dengan non parametrik tergantung situasi pelanggarannya.

(1).Jika distribusi data kita ternyata multi modal (memiliki beberapa puncak atau beberapa observasi dengan jumlah subjek cukup banyak), maka kita mencurigai adanya subsampel-subsampel. Kita perlu mengidentifikasi subsampel-subsampel ini dan menjadikannya sebagai faktor / variabel baru dalam model. Dengan demikian kita menggunakan teknik analisis lain, yaitu Analisis Varians Dua Jalur.

(2).Jika ketidaknormalan tidak terlalu parah kita dapat meneruskan analisis dengan alasan t-test merupakan uji yang robust terhadap ketidaknormalan.

(3).Kita bisa mentransform data kita menggunakan operasi matematik tertentu tergantung kondisi ketidaknormalan.

(4).Ya apalagi selain menggunakan analisis non-parametrik. Namun perlu diingat, bahwa meskipun analisis non parametrik tidak mensyaratkan bentuk distribusi tertentu, mereka tetap memiliki asumsi yang perlu dipenuhi juga. Ya distribution free statistics tidak sama dengan assumption free statistics (yang setahu saya memang nggak ada statistik yang bebas dari asumsi). Selain itu statistik non parametrik tidak cukup baik digunakan untuk desain yang kompleks (seperti desain dengan dua variabel independen).

Homogenitas Varians antar Kelompok

Homogenitas Varians…selain punya nama lain yang keren, ini memang asumsi yang cukup penting. Pelanggaran terhadap asumsi ini bisa berakibat fatal terhadap kesimpulan yang kita ambil dari analisis statistik. Asumsi ini berlaku khususnya ketika kita berurusan dengan t-test untuk sampel yang independen. Asumsi ini tidak dibutuhkan untuk t-test satu sampel, karena hanya ada satu sampel yang dianalisis. Juga tidak dibutuhkan untuk t-test sampel yang berhubungan, karena varians kelompok antara waktu yang satu dengan berikutnya biasanya homogen.

Nama lain Homogenitas Varians ini adalah Homoscedasticity (baca: homoskedastisiti, cobalah menyebutkan dengan kecepatan normal hehe… bahkan teman-teman kuliah saya yang belajar statistik juga kesulitan menyebutkannya. Homosceblablabla…). Lawan dari homoscedasticity adalah heteroscedasticity. Jika kondisi homoscedasticity terpenuhi dapat dikatakan varians antar kelompok memiliki besar yang sama. Jika varians antar kelompok tidak sama, kita sebut kondisi ini sebagai heteroscedasticity. OK cukup untuk latihan menyebutnya.

Homogenitas Varians di sini tentu saja terkait dengan homogenitas varians di populasi bukan di sampel. Jadi perbedaan varians yang tidak terlalu besar antara kelompok satu dengan yang lain tidak akan berakibat parah. Pelanggaran asumsi ini dapat terjadi atau perlu diwaspadai jika :

(1). Kita membandingkan kelompok berdasarkan gender, status sosial-ekonomi, atau klasifikasi lain. Seringkali terjadi kelompok-kelompok ini secara alami (dari sononya…) memang memiliki perbedaan varians.

(2). Treatmen dalam penelitian eksperimental terkadang juga dapat mempengaruhi variasi skor subjek selain meannya.

(3). Dalam beberapa pengukuran, seperti waktu reaksi, variasi subjek seringkali mengikuti kuantitasnya. Maksudnya dalam kelompok yang memiliki waktu reaksi yang kecil, variasi subjek juga cenderung kecil, sementara pada kelompok dengan waktu reaksi yang besar, variasi subjek juga cenderung besar.

Bagaimana buktiin kalo varians antar kelompok dalam penelitian itu homogen atau tidak? Setelah saya pikir agak lama, sepertinya pembahasan mengenai cara pembuktian ini akan ditulis dalam posting sendiri saja biar lebih detil. Sekaligus cara mencari lewat program SPSS nya.

Lalu apa dampaknya? Beberapa ahli mengatakan bahwa dampak heteroscedasticity ini tidak akan terlalu parah jika kita membandingkan sampel dengan jumlah subjek yang sama. Tetapi dalam penelitian terakhir ditemukan bahwa bahkan dalam sampel dengan jumlah yang sama pun, pelanggaran ini dapat berakibat cukup parah. (Sebagai ilustrasi dapat dilihat dalam Keppel & Wickens, 2004, hal.149).

Ketidakakuratan ini makin diperparah jika besarnya sampel antara kedua kelompok tidak sama, dan juga ketika sampel yang memiliki jumlah subjek terkecil ternyata memiliki varians yang besar. Selain itu pengujian hipotesis berarah juga dapat membuat test makin sensitif terhadap pelanggaran asumsi ini.

Terkait dengan jumlah sampel yang tidak sama, ada prinsip seperti ini:

(1). Jika hubungan antara besar sampel dan varians positif, dalam hal ini sampel yang kecil memiliki variasi yang kecil sementara sampel yang besar memiliki variasi yang besar, maka nilai p yang kita dapatkan dari hasil analisis cenderung lebih besar dari yang sebenarnya. Kondisi ini disebut juga uji statistik kita tergolong konservatif. Dalam hal ini, kesimpulan kita akan memiliki error tipe I yang kecil, tapi cenderung untuk melakukan error tipe II lebih besar.

(2). Jika hubungan antara besar sampel dan varians negatif, yaitu ketika sampel yang kecil memiliki varians yang besar sementara sampel yang besar memiliki varians yang kecil, nilai p yang kita dapatkan cenderung lebih besar dari yang sebenarnya. Jadi jika dari hasil analisis kita dapatkan p=0.05 maka p yang sebenarnya lebih besar (misal p=0.2). Dalam hal ini kita cenderung melakukan error tipe I lebih besar. Jadi ketika kita menyimpulkan hipotesis nol ditolak, sebenarnya hipotesis nol seharusnya tidak ditolak. Kondisi ini disebut juga uji statistik kita tergolong liberal.

Jadi apa yang bisa kita lakukan untuk menghindari kesimpulan yang keliru?

(1). Beberapa ahli menyebutkan jika perbandingan antara varians terbesar dengan terkecil tidak lebih besar dari 4, maka t-test dapat dilakukan tanpa perlu kuatir mengenai heteroscedasticity.

(2). Beberapa ahli lain menyarankan cara yang konservatif (mengurangi tipe error I sekecil mungkin). Cara pertama dengan membagi dua besarnya alpha (tipe error I), atau kita sering menyebutnya taraf signifikasi yang akan kita pakai. Jadi jika kita ingin menggunakan taraf signifikasi 5%, maka sekarang kita mengacu pada taraf signifikasi sebesar 2.5% di tabel.

(3) Cara lain yang konservatif adalah dengan memperkecil db yang kita pakai untuk konsultasi ke tabel. Cara ini ditempuh dengan memilih salah satu sampel dengan n terkecil kemudian mengurangi jumlah subjek dalam sampel ini dengan 1. Jadi dbnya sekarang menjadi nterkecil-1, bukan (n1 + n2 - 2) lagi.

(4) Selain itu kita dapat juga menggunakan db yang dihitung ulang menggunakan formula tertentu untuk meningkatkan akurasi estimasi p. (Saya tidak mencantumkan rumusnya di posting ini, tapi bagi yang berminat dapat mengubungi saya).

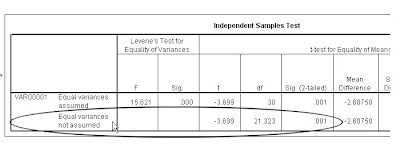

Tapi kita tidak perlu repot menghitungnya, karena selain ribet, juga kita tetap akan kesulitan untuk konsultasi ke tabel karena db yang dihasilkan pasti berbentuk pecahan. Kebayang nggak liat tabel t mencari nilai kritis t untuk db 7.8932? Lalu? Perhitungan ini yang ditampilkan di SPSS di baris equal variances not assumed. Ya, jadi perhitungan di SPSS itu berasal dari rumus ini. (“Bilang kek dari tadi, tiwas deg degan harus itung manual,” sepertinya saya bisa mendengar suara ini). Seperti gambar di bawah ini:

Nah jika di SPSS kita bisa melihat baris ini jika kita meragukan homogenitas varians data kita. Kita bandingkan df (db) di baris atas sebesar 30 dan di bawahnya adalah db yang telah diadjust menjadi 21.323.

(5) Cara kelima ini terkait dengan mengganti analisis dengan analisis yang memungkinkan adanya perbedaan varians di antara kelompok. Kita bisa menggunakan Brown-Forsythe atau James second order method. Kita nggak akan bahas ini banyak di sini ya. Dalam program SPSS hanya ada prosedur Brown-Forsythe atau Welch untuk melakukan analisis yang lain ini.

(6) Cara terakhir untuk berurusan dengan pelanggaran homogenitas varians adalah dengan mentransform data. Ini hanya dilakukan jika kita yakin bahwa hasil transform data tidak akan mengubah esensi data kita (misalnya tidak akan mengubah kondisi berbeda mean menjadi tidak berbeda) atau hasil transform memiliki korelasi yang sangat tinggi dengan data sebelum ditransform.

Demikianlah kiranya pembahasan mengenai asumsi-asumsi dalam t-test. Banyak pemikiran di dalamnya saya ambil dari buku Keppel & Wickens, 2004. Sementara yang lain dari

Further

Howell, D. C., (1986) Statistical methods for psychology.

Moore, D. S.(2007) The basic practice of statistics. Fourth edition.

Tidak ada komentar :

Posting Komentar